L’Intelligenza Artificiale è ormai entrata in ogni conversazione sul futuro. Ma quando diciamo “A.I.”, di cosa stiamo realmente parlando?

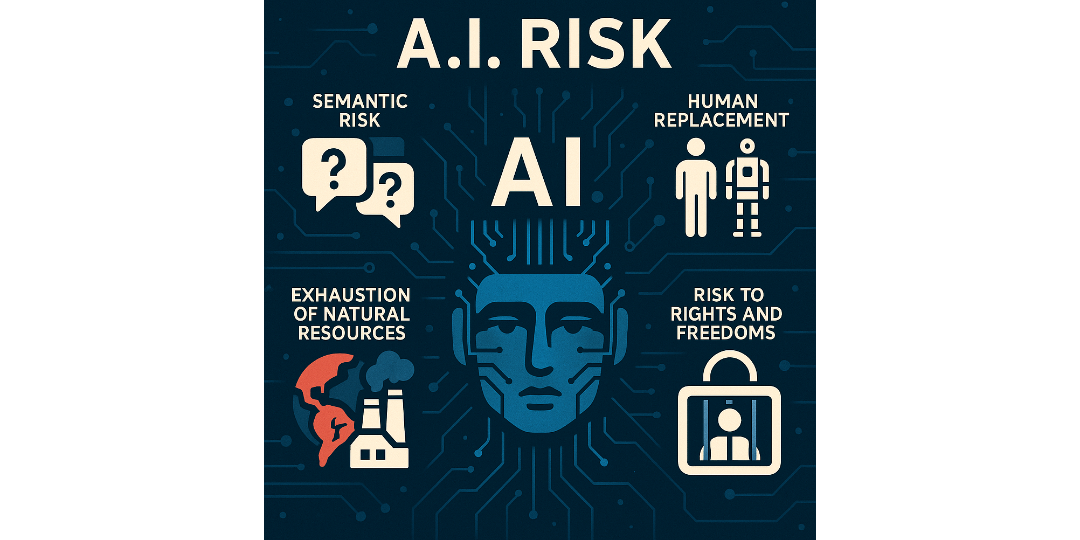

Un concetto polisemico, che porta con sé opportunità enormi, ma anche rischi sistemici che vanno compresi e governati. In questo articolo, esploriamo quattro rischi chiave legati all’adozione crescente dei sistemi di intelligenza artificiale.

1. Il rischio semantico: di cosa parliamo quando parliamo di A.I.?

Il termine Intelligenza Artificiale è un contenitore ambiguo. Si parla di “sistemi di A.I.”, “strumenti di A.I.”, “software di A.I.”, ma ogni espressione evoca significati diversi. Questa polisemanticità può generare confusione normativa, strategica e culturale.

Per alcuni, l’A.I. è un algoritmo di apprendimento automatico. Per altri, è un insieme di tecnologie che imitano funzioni cognitive umane. Per il grande pubblico, è una sorta di “cervello elettronico” quasi magico.

Il rischio semantico consiste proprio qui: se non sappiamo con precisione di cosa stiamo parlando, diventa difficile normare, governare e perfino valutare i reali impatti dell’A.I.

2. Il rischio della sostituzione umana

L’A.I. è spesso presentata come alleata del lavoro umano, ma cresce il timore che diventi sostituta. Professioni ripetitive o basate sull’elaborazione di grandi quantità di dati sono già a rischio di automazione.

Contabilità, call center, traduzioni, persino ambiti creativi come il copywriting e il design.

Il rischio non è soltanto occupazionale, ma esistenziale: se deleghiamo troppo all’A.I., cosa resta della competenza, della creatività, del giudizio umano?

La vera sfida non è solo difendere i posti di lavoro, ma ripensare il lavoro stesso, valorizzando ciò che le macchine non possono replicare: empatia, etica, intuizione.

3. Il rischio dell’esaurimento delle risorse naturali

C’è un lato oscuro, spesso ignorato, dell’A.I.: il suo costo ambientale.

L’addestramento di GPT-3 ha richiesto un consumo energetico equivalente a 20 anni di una famiglia media.

Nel 2022, i data center hanno assorbito circa il 2% della produzione mondiale di elettricità – una quota destinata a crescere con l’espansione dell’A.I. generativa.

Dietro la leggerezza di un prompt digitato, si nasconde un’impronta energetica pesante. Il rischio è che l’innovazione acceleri il degrado delle risorse naturali, anziché contribuire a preservarle. La sostenibilità dell’intelligenza artificiale diventa quindi un tema centrale, tanto quanto la sua efficacia tecnologica.

4. Il rischio per i diritti e le libertà delle persone

Forse il rischio più delicato: l’impatto sui diritti fondamentali.

Sistemi di sorveglianza basati su A.I. possono minare la privacy. Algoritmi decisionali opachi possono introdurre bias e discriminazioni. Il controllo sociale attraverso strumenti predittivi rischia di ridurre le libertà individuali.

Il principio “non lasciare nessuno indietro”, cardine dell’Agenda 2030, viene qui messo alla prova: come garantire che l’A.I. sia strumento di inclusione e non di esclusione?

L’A.I. non è una forza autonoma, ma il riflesso delle nostre scelte progettuali, industriali e politiche. Parlare di rischi significa anche aprire la strada a un uso più consapevole e responsabile.

Serve chiarezza semantica, per evitare ambiguità.

Serve un modello di lavoro che integri, non sostituisca.

Serve una governance ambientale dell’A.I. per limitarne l’impronta.

Serve una cornice etico-legale per proteggere diritti e libertà.

L’Intelligenza Artificiale sarà tanto più utile quanto più sapremo domarla con intelligenza umana.

Diffondi questo contenuto